NVIDIA ADA Lovelace och GeForce RTX 40-serien: Allt vi vet | Toms hårdvara, Asus GeForce RTX 40 -serien grafikkort

Asus GeForce RTX 40 -serien grafikkort

Vi hade två långa år av GPU-torka och överdrivna kort för NVIDIAs tidigare generation AMPERE / RTX 30-serien GPUS. Slutet av 2022 markerade ankomsten av de första nästa gen-GPU: erna, men de var alla mycket dyra, började på $ 800 minimum. 2023 formar sig under tiden för att bli bättre för dem som vill köpa en mainstream -uppgradering.

Nvidia Ada Lovelace och GeForce RTX 40-serien: Allt vi vet

NVIDIAs ADA-arkitektur och GeForce RTX 40-serien grafikkort började levereras först den 12 oktober 2022, med början med GeForce RTX 4090. GeForce RTX 4080 följde en månad senare den 16 november 2022, sedan lanserades RTX 4070 TI (tidigare RTX 4080 12GB) den 5 januari 2023, och senast var RTX 4070 lanseringen den 13 april 13 april. Det är två år efter Nvidia ampere arkitektur och i princip rätt enligt schemat med tanke på att avmattas (eller om du föredrar, död) av Moores lag.’Det är också bra nyheter eftersom de bästa grafikkorten behövde någon ny tävling.

Med Nvidia hack Tidigt 2022 hade vi en hel del information om vad vi kan förvänta oss. Korten levereras nu och NVIDIA har bekräftat specifikationer på de många av RTX 40-seriens kort. Vi har samlat allt i detta centrala nav som beskriver allt vi vet och förväntar oss av Nvidias ADA-arkitektur och familjen RTX 40-serien.

Det finns fortfarande rykten som virvlar runt, mestadels om framtida Ada Lovelace-kort som de ryktade Titan RTX ADA / RTX 4090 TI, och de lägre nivåmodellerna som RTX 4060-klassen och RTX 4050-och dessa lägre spec GPU: er levereras redan i NVIDIA RTX 40-serie mobila lösningar. Men modellnummer har vi nu en bra uppfattning om vad vi kan förvänta oss av ADA Lovelace Architecture. Med ADA -whitepaperen som nu är tillgänglig vid sidan av GPU: er har vi uppdaterat informationen här för att täcka exakt vad den nya generationen GPUS levererar.

Den första salven av Desktop RTX 40-serien kort har lanserat. Om NVIDIA följer ett liknande släppplan som tidigare, kan vi förvänta oss att resten av RTX 40-serien kommer att sippra ut under nästa år. RTX 4060 Ti bör anlända i maj, med alternativ RTX 4060 Ti 16 GB och RTX 4060 -modeller i juli, och slutligen kommer det (kanske?) vara en 4050 någon gång i sommar. Låt oss börja med den höga nivåöversikten av specifikationerna och ryktade specifikationerna för ADA -serien av GPU: er.

GeForce RTX 40-serien specifikationer och spekulation

Svep för att bläddra horisontellt

| Grafikkort | RTX 4090 TI / TITAN? | RTX 4090 | RTX 4080 | RTX 4070 TI | RTX 4070 | RTX 4060 TI | RTX 4060 | RTX 4050 |

|---|---|---|---|---|---|---|---|---|

| Arkitektur | AD102 | AD102 | AD103 | AD104 | AD104 | AD106 | Ad107 | Ad107 |

| Processteknik | TSMC 4N | TSMC 4N | TSMC 4N | TSMC 4N | TSMC 4N | TSMC 4N | TSMC 4N | TSMC 4N |

| Transistorer (miljarder) | 76.3 | 76.3 | 45.9 | 35.8 | 35.8 | 22.9 | 18.9 | 18.9 |

| Die -storlek (mm^2) | 608.4 | 608.4 | 378.6 | 294.5 | 294.5 | 187.8 | 158.7 | 158.7 |

| SMS / CUS / XE-CORES | 142 | 128 | 76 | 60 | 46 | 34 | 24 | 18? |

| GPU -kärnor (skuggare) | 18176 | 16384 | 9728 | 7680 | 5888 | 4352 | 3072 | 2304? |

| Tensorkärnor | 568 | 512 | 304 | 240 | 184 | 136 | 96 | 72? |

| Strålspårning “kärnor” | 142 | 128 | 76 | 60 | 46 | 34 | 24 | 18? |

| Boost Clock (MHz) | 2625? / 2520? | 2520 | 2505 | 2610 | 2475 | 2535 | 2460 | 2500? |

| VRAM -hastighet (GBPS) | 24? | 21 | 22.4 | 21 | 21 | 18 | 17 | 16? |

| VRAM (GB) | 24/48 | 24 | 16 | 12 | 12 | 8/16 | 8 | 8? |

| Vram bussbredd | 384 | 384 | 256 | 192 | 192 | 128 | 128 | 128? |

| L2 -cache | 96 | 72 | 64 | 48 | 36 | 32 | 24 | 24? |

| Rop | 192 | 176 | 112 | 80 | 64 | 48 | 48 | 48? |

| Tmus | 568 | 512 | 304 | 240 | 184 | 136 | 96 | 72? |

| TFLOPS FP32 (boost) | 95.4? / 91.6? | 82.6 | 48.7 | 40.1 | 29.1 | 22.1 | 15.1 | 11.5? |

| TFLOPS FP16 (FP8) | 763 (1527) / 733 (1466) | 661 (1321) | 390 (780) | 321 (641) | 233 (466) | 177 (353) | 121 (242) | 92 (184)? |

| Bandbredd (GBPS) | 1152 | 1008 | 717 | 504 | 504 | 288 | 272 | 256? |

| TDP (watt) | 600? / 800? | 450 | 320 | 285 | 200 | 160 | 115 | 80? |

| Lanseringsdag | April ~ juni? | 2022 oktober | 2022 november | 2023 jan | 2023 april | Maj/juli 2023? | Juli 2023? | ~ Aug 2023? |

| Lanseringspris | Mycket | 1,599 $ | 1,199 $ | 899 $ | 599 $ | $ 399/$ 499 | $ 299 | 249 $? |

Allt kort förutom RTX 4050 är nu officiellt och specifikationerna är helt exakta. Det finns rykten för RTX 4050, men specifikationerna är mer antaganden baserat på vad vi vet om Mobile RTX 4050 och skrivbordet RTX 4060. Med andra ord, applicera salt generöst på RTX 4090 Ti och/eller Titan och 4050 information, eftersom de är mer spekulationer än vad som helst konkreta. Nvidia har inte officiellt avslöjat ens förekomsten av dessa kort, och det kommer inte förrän de är närmare att släppa.

Det kommer sannolikt också att finnas ytterligare kort som tillkännages i framtiden för uppdateringen av mitten av cykeln (i.e. Liknar 3080 Ti och 3070 Ti, eller före så 2080/2070/2060 Super Models).

Visst finns det gott om utrymme i toppen för en framtida RTX 4090 TI. Observera att den maximala L2 -cachen skärs ner på 4090 (tolv block på 6 MB istället för tolv block på 16 MB), ROPS trimmas lite, och NVIDIA kan säkert pressa högre på klockor och kraft. och pris. [Suck.] Men medan trovärdiga rykten om ett 4-slår Founders Edition-kort har cirkulerat, är ingenting officiellt.

Vi vet att Nvidia träffar klockhastigheter på 2.5–2.6 GHz på RTX 40-serien GPUS hittills, och vi förväntar oss liknande eller till och med högre klockor på alla framtida GPU: er i lineupen. Officiella specifikationer och verkliga klockor är inte samma sak, eftersom RTX 4070 till exempel listar en 2475 MHz boostklocka medan han testade RTX 4070 Founders Edition rutinmässigt bröt 2700 MHz. NVIDIA har också framgångsrikt överklockat RTX 4090 till 3.0GHz och därefter. Vi har lagt in en tentativ klockhastighetsuppskattning på 2.5 GHz på den utan tillkännagivande 4050 GPU för nu.

De sex (sju om du räknar 4060 Ti 16 GB som ett separat kort) släppt/tillkännagivna modeller använde fem olika GPU: er, vilket är en förändring från tidigare lanseringar. RTX 4090 använder en betydligt trimmad AD102 -implementering (89% av kärnorna, 75% av cachen). Samtidigt använder RTX 4080 ett “nästan komplett” AD103 -chip (95% av kärnorna och all cache), RTX 4070 TI använder ett helt aktiverat AD104 -chip, och RTX 4070 använder 77% av ett AD104 -chip. RTX 4060 TI använder det mesta av en AD106 (94%), medan RTX 4060 använder hela AD107 -chipet. Återigen kan vi förvänta oss antingen skördade eller mer helt aktiverade varianter av varje GPU vid någon tidpunkt.

Nvidia “gick stort” med AD102 GPU, och det är närmare i storlek och transistor räknas till H100 än GA102 var till GA100. Ärligt talat, det är ett monster, med prestanda och pris att matcha. Den packar i mycket mer SMS och de tillhörande kärnorna än någon AMPERE GPUS, den har mycket högre GPU -klockor, och den innehåller också ett antal arkitektoniska förbättringar för att ytterligare öka prestanda. NVIDIA hävdade att RTX 4090 är 2x–4x snabbare än den utgående RTX 3090 TI, även om varningar gäller för dessa riktmärken.

Vår egen testning sätter prestanda på mer som 60% snabbare i sammanlagt jämfört med föregående generation RTX 3090 TI. Det är på 4K och maxade in inställningar, utan DLSS 2 eller DLSS 3. Men som vi noterade i våra recensioner, medan DLSS 3 -ramgenerering kan öka ramfrekvensen, är det inte detsamma som “riktiga” ramar och det lägger vanligtvis till latens, vilket betyder att det känns mer som en förbättring på 10–20 procent jämfört med baslinjen prestanda. Det är också värt att notera att om du för närvarande kör en mer blygsam processor snarare än en av de absolut bästa CPU: erna för spel, kan du mycket väl hamna CPU Limited även vid 1440p ultra med 4090. En större systemuppgradering kommer sannolikt att vara nödvändig för att få ut mesta möjliga av de snabbaste Ada GPU: erna.

TSMC 4N: “4nm nvidia”

NVIDIA använder TSMC: s 4N -process – “4nm NVIDIA” – på alla ADA GPU: er, från Big AD102 och Hopper H100 ner till den minsta AD107. TSMC: s 4N -nod är en finjusterad och förfinad variation på TSMC: s N5 -nod som har använts allmänt i andra chips, och som också används för AMDs Zen 4 och RDNA 3. Vi tror inte att Samsung kommer att ha ett övertygande alternativ som inte kräver en allvarlig omdesign av kärnarkitekturen, så hela familjen kommer att vara på samma nod.

TSMC N4 erbjuder flera stora förbättringar jämfört med Samsung 8n (“8nm nvidia”) som används på Ampere. Specifikt har den mycket mindre funktioner, vilket innebär att Nvidia kan packa i mycket fler transistorer i ett liknande eller mindre område. AD102 till exempel har 76.3 miljarder transistorer i en 608mm^2 matstorlek, eller i genomsnitt cirka 125 miljoner transistorer per kvadratmillimeter (mtrans/mm^2). AD103/106/107 Erbjud en liknande 119 ~ 121 densitet, medan AD104 är det minst täta chipet med “endast” 109 mtrans/mm^2. Ampere GA102/104/106 GPU: er i jämförelse packade cirka 43 ~ 45 mtrans/mm^2.

N4 -processnoden möjliggör också lägre effektanvändning och förbättrad effektivitet. Ja, RTX 4090 har en massiv 450W TGP (Total Graphics Power) budget, men över en 15 -speltestsvit var det i genomsnitt 390W vid 4K Ultra -inställningar i vår testning. De mest krävande spelen kunde dra 450W, medan andra bara behövde cirka 300 ~ 325 watt. Och det är det värsta exemplet från ADA; RTX 4080, 4070 TI och 4070 är alla högst upp i vår effektivitetsmetrisk, vad gäller FPS per watt.

Slutligen, som nämnts ovan, är klockhastigheterna mycket högre med ADA än med Ampere. Officiella klockor har ökat från 1 665–1 860 MHz med ampere (beroende på modell), till ett intervall av 2 475–2,610 MHz med ADA. Det är i genomsnitt 40 till 50 procent högre klockor, även om de verkliga klockorna för både Ampere och ADA tenderar att vara cirka 200 MHz högre än de officiella boostklockorna.

ADA ökar massivt beräkningsprestanda

Med den höga överblicken ur vägen, låt oss komma in i detaljerna. Den mest märkbara förändringen med ADA GPU: er kommer att vara antalet SMS jämfört med den nuvarande ampere -generationen. Överst packar AD102 potentiellt 71% mer SMS än GA102. Även om inget annat skulle förändras väsentligt i arkitekturen, kan vi förvänta oss att det ska ge en enorm ökning av prestanda.

Som inte bara kommer att gälla för grafik utan också för andra element. . Varje 4: e generationens tensorkärna kan utföra 256 FP16 -beräkningar per klocka, dubbelt så med sparsitet och dubbelt så igen med FP8 och Sparsity. RTX 4090 har teoretiskt djupt inlärning/AI -beräkning av upp till 661 teraflops i FP16, och 1 321 teraflops av FP8 – och ett helt aktiverat AD102 -chip kan träffa 1..

Hela GA102 i RTX 3090 Ti efter jämförelse toppar ut på cirka 321 TFLOPS FP16 (igen, med NVIDIAs Sparsity -funktion). Det betyder att RTX 4090 levererar en teoretisk ökning med 107%, baserad på kärnantal och klockhastigheter. Samma teoretiska uppsving i prestanda gäller också för skugg- och strålspårningshårdvaran, förutom att de också förändrar.

GPU -skuggkärnorna kommer att ha en ny Shader Execution Reordering (SER) som NVIDIA hävdar kommer att förbättra allmänna prestanda med 25%och kan förbättra strålspårningsverksamheten med upp till 200%. Tyvärr kommer stödet för SER att kräva att utvecklare använder egenutvecklade NVIDIA -tillägg, så befintliga spel kommer inte nödvändigtvis att gynnas.

RT -kärnorna har under tiden fördubblats på Ray/Triangle -korsningens hårdvara (eller åtminstone genomströmningen per kärna), plus att de har ett par nya knep tillgängliga. Opacity Micro-Map (OMM) -motorn möjliggör betydligt snabbare strålspårning för transparenta ytor som bladverk, partiklar och staket. Den fördrivna mikro-mesh (DMM) -motorn optimerar å andra sidan genereringen av begränsningsvolymhierarkin (BVH) -strukturen, och NVIDIA hävdar att den kan skapa BVH upp till 10x snabbare medan du använder 20x mindre (5%) minne för BVH-lagring. Återigen kräver dessa att utvecklare använder sig av de nya funktionerna, så befintliga Ray Tracing -spel inte kommer att gynnas utan en patch.

Tillsammans bör dessa arkitektoniska förbättringar göra det möjligt för Ada Lovelace GPU: er att erbjuda ett massivt generationsprång i prestanda. Förutom att det kommer att vara upp till utvecklare att möjliggöra de flesta av dem, så att upptag kan vara ganska minskat.

Ada Lovelace ROPS

ADA: s ROP -räkningar går upp ganska mycket i vissa fall, särskilt toppmodellen (för nu) RTX 4090. . Varje GPC får vanligtvis 16 ROPS.

AD102 har upp till 144 SMS med 12 GPC på 12 SMS vardera. Det ger 192 ROPS som maximalt, även om det slutliga numret på RTX 4090 är 11 GPC och 176 ROPS. RTX 4080 Gas Seven GPCS, precis som GA102, men i en udda taktförändring verkar det som en av GPC -klusterna bara har 8 SMS medan de andra sex har upp till 12 SMS. Hur som helst, alla sju är aktiverade på RTX 4080 och det har 112 ROPS. AD104 i RTX 4070 TI och 4070 använder fem GPC: er på 12 SMS, med 80 ROPS.

För närvarande bör de återstående korten tas som en bästa gissning. Vi vet inte med säkerhet vad GPU: er kommer att användas, eller hur många GPC som kommer att vara aktiva på varje. Vi kommer att fylla i tomma ämnen när mer information blir tillgänglig under de kommande månaderna, när de andra Ada GPU: erna har lanserat.

Memory Subsystem: GDDR6X Rides Again

Förra året meddelade Micron att det har färdplaner för GDDR6X -minne som körs med upp till 24 Gbps. Den senaste RTX 3090 TI använder bara 21 Gbps -minne, och NVIDIA är för närvarande det enda företaget som använder GDDR6X för något. Det väcker omedelbart frågan om vad som kommer att använda 24 Gbps GDDR6X, och det enda rimliga svaret verkar vara NVIDIA ADA. GPU: s lägre nivå är mer benägna att hålla sig till standard GDDR6 snarare än GDDR6X, som toppar ut på 20 Gbps och används i AMD: s RX 7900 XTX/XT-kort.

Officiellt använder RTX 4090, 4070 TI och 4070 alla 2 GB -chips betygsatta för 21 Gbps. RTX 4080 är undantaget, med 2 GB -chips betygsatt för 22.4Gbps. Förutom att Micron inte gör 22.4 Gbps -chips, så de är faktiskt 24 Gbps chips som klockas mer konservativt. Anekdotiskt, i vår demontering av flera RTX 40-serie GPU: er, har vi lagt märke till att några av “21 Gbps” -korten har minne som går svalare och överklockor bättre, slår upp till 25 Gbps. Vi antar att Micron bara är nedåtgående några chips och att utbytet på 24 Gbps-minnet är ganska bra nu.

Att ha samma toppbandbredd som RTX 3090 TI representerar lite av ett problem, eftersom GPU: er i allmänhet behöver beräkna och bandbredd för att skala proportionellt för att inse den utlovade mängden prestanda. RTX 3090 TI har till exempel 12% mer dator än 3090, och det högre klockade minnet ger 8% mer bandbredd. Baserat på de datordetaljerna som visas ovan finns det en enorm kopplingsbryggning. RTX 4090 har cirka dubbelt så mycket beräkning som RTX 3090 Ti, men den erbjuder samma 1008 GB/s bandbredd – 24 Gbps för en eventuell RTX 4090 TI, vem som helst?

Det finns mycket mer utrymme för bandbredd att växa på de nedre nivån GPU: er, förutsatt att GDDR6X strömförbrukning kan hållas i schack. Den nuvarande RTX 3050 till RTX 3070 använder alla standard GDDR6 -minne, klockat på 14–15 Gbps. Vi vet redan att GDDR6 som körs på 20 Gbps är tillgängligt, så en hypotetisk RTX 4050 med 18 Gbps GDDR6 borde enkelt hålla jämna steg med ökningen av GPU -beräkningskraften. Om NVIDIA fortfarande behöver mer bandbredd kan den knacka på GDDR6X för de lägre nivåerna GPU: er också.

Fångsten är att Nvidia inte gör det behöver Massiva ökningar av ren minnesbandbredd, för istället omarbetade den arkitekturen, liknande det vi såg AMD göra med rDNA 2 jämfört med den ursprungliga rDNA -arkitekturen. Nämligen kommer det att packa in mycket mer L2 -cache för att lindra kraven på minnesundersystemet.

ADA passar in på L2 -cache

Ett bra sätt att minska behovet av mer råminnesbandbredd är något som har varit känt och använt i årtionden. Slå mer cache på ett chip och du får fler cache -hits, och varje cache -hit betyder att GPU inte behöver dra data från GDDR6/GDDR6X -minnet. En stor cache kan vara särskilt användbar för spelprestanda. AMD: s Infinity Cache tillät RDNA 2 -chips att i princip göra mer med mindre rå bandbredd och NVIDIA ADA L2 -cache visar att NVIDIA har tagit ett liknande tillvägagångssätt.

AMD använder en massiv L3 -cache på upp till 128 MB på Navi 21 GPU, med 96 MB på NAVI 22, 32 MB på Navi 23 och bara 16 MB på Navi 24. AMD har också 96 MB L3 -cache på den nya Navi 31. Överraskande gör till och med den mindre 16MB -cachen underverk för minnesundersystemet. Vi trodde inte Radeon RX 6500 XT var ett stort kort totalt sett, men det håller i princip upp med kort som har nästan dubbelt så mycket som minnesbandbredden.

ADA-arkitekturen parar upp till en 8MB L2-cache med varje 32-bitars minneskontroll, eller 16 MB per 64-bitars styrenhet. Det betyder att korten med ett 128-bitars minnesgränssnitt skulle få 32 MB total L2-cache, och 384-bitarsgränssnittet på AD102 har upp till 96 MB L2-cache. Förutom att en del av L2 -cache -blocken också kan inaktiveras, så RTX 4090 har bara 72 MB L2 -cache (tolv block på 6 MB istället för 8 MB), och några av de andra ADA -modellerna kommer troligen att ta en liknande strategi.

Även om det är mindre än AMD: s RDNA 2 Infinity Cache i många fall, sjönk AMD också till 96 MB Total L3 -cache för sin topp RX 7900 XTX. Vi känner inte heller latenser eller andra aspekter av designen än. L2 -cache tenderar att ha lägre latenser än L3 -cache, så en något mindre L2 kan definitivt hålla jämna steg med en större men långsammare L3 -cache, och som vi såg med RDNA 2 GPU: er, till och med en 16 MB eller 32 MB Infinity Cache hjälpte mycket mycket mycket.

Om vi tittar på AMD: s RX 6700 XT som ett exempel. Den har cirka 35% mer dator än föregående generation RX 5700 XT. GPU -riktmärken hierarki Under tiden är cirka 32% högre vid 1440p ultra, så prestanda totalt skalas ganska mycket i linje med datorn. Förutom att 6700 XT har ett 192-bitars gränssnitt och endast 384 GB/s bandbredd, 14% lägre än RX 5700 XT: s 448 GB/s. Det betyder att Big Infinity Cache gav AMD minst 50% uppsving till effektiv bandbredd.

I allmänhet ser det ut som att Nvidia får liknande resultat med ADA, och även utan bredare minnesgränssnitt ska ADA GPU: er fortfarande ha gott om effektiv bandbredd. Det är också värt att nämna att Nvidias minneskomprimeringstekniker i tidigare arkitekturer har visat sig vara kapabla, så lite mindre cachar jämfört med AMD kanske inte spelar någon roll alls.

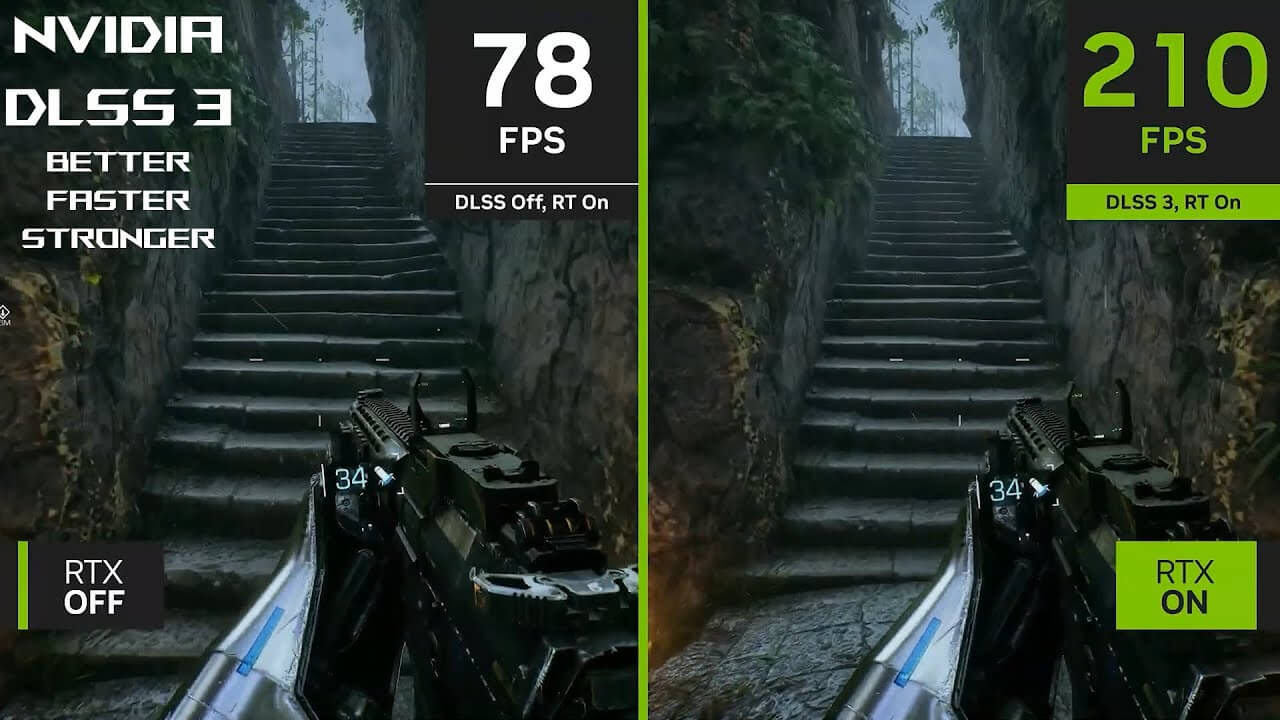

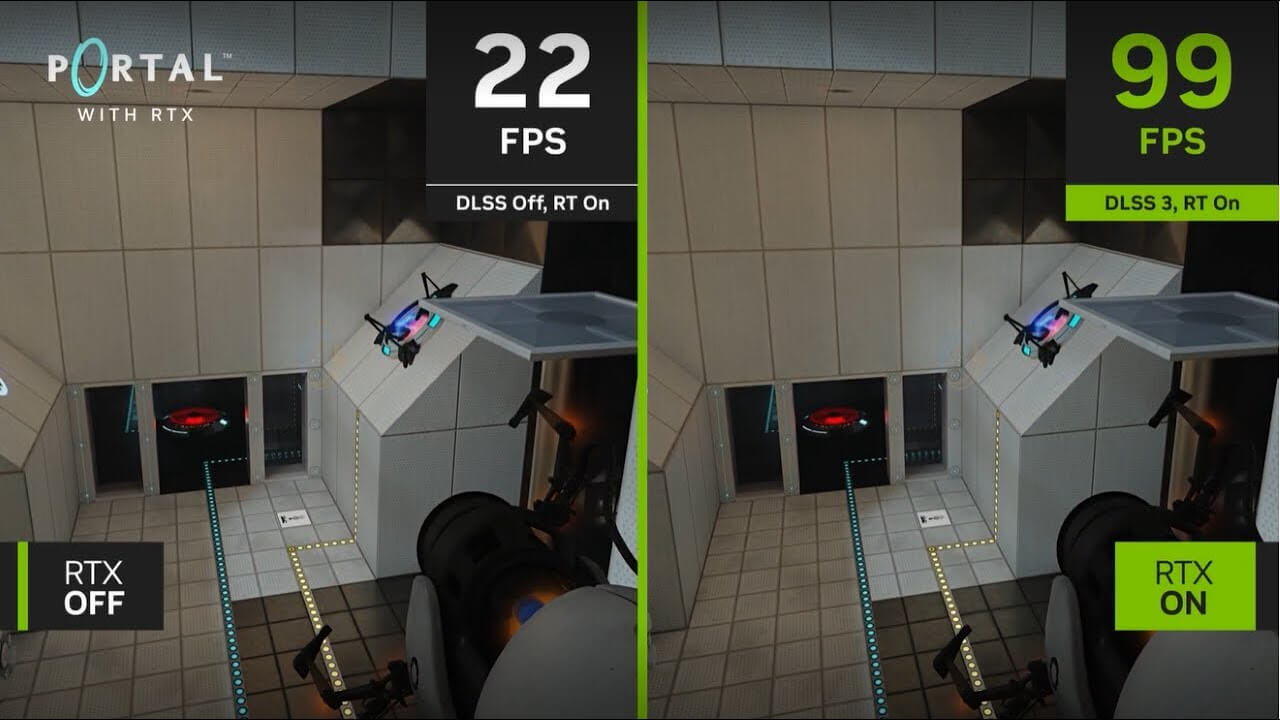

RTX 40-serien får DLSS 3

En av de stora tillkännagivanden med RTX 40-serien och Ada Lovelace är DLSS 3, vilket kommer endast Arbeta med RTX 40-seriens grafikkort. Där DLSS 1 och DLSS 2 arbetar på både RTX 20- och 30-seriens kort och kommer också att arbeta på ADA GPU: er, DLSS 3 förändrar grundläggande vissa saker i algoritmen och kräver uppenbarligen de nya arkitektoniska uppdateringarna.

Ingångar till DLSS 3 -algoritmen är mestadels desamma som tidigare, men nu finns det en uppdaterad optisk flödesaccelerator (OFA) som tar två tidigare ramar och genererar ytterligare rörelsevektorer som sedan kan matas in i den optiska multiframgenereringsenheten. I kombination med DLSS -prestandaläge -uppskalning innebär ramgenerering att GPU potentiellt bara måste göra 1/8 av pixlarna som skickas till skärmen.

Förresten, OFA är inte Nytt med Ada. Turing och Ampere hade också en fast funktion av ett block, bara det var inte så performant eller så kapabelt. Typiska användningsfall för OFA tidigare inkluderade att minska latensen i förstärkt och virtuell verklighet, förbättra jämnheten i videouppspelning, förbättra videokomprimeringseffektiviteten och möjliggöra stabilisering av videokamera. Det användes också med bil- och robotnavigering och videoanalys och förståelse.

. Den extra prestanda och andra förbättringar gör det möjligt att användas för att skapa det optiska flödesfältet som är en del av DLSS 3 -ramgenerering. Medan ADA OFA: s högre prestanda och kapacitet för närvarande krävs för DLSS 3, finns det lite wiggle -rum. Nvidias Bryan Catanzaro, VP för tillämpad djupinlärningsforskning, tweetade att det var ”teoretiskt möjligt” för DLSS 3 att så småningom arbeta med Ampere GPU: er. Det skulle troligen köra vid lägre kvalitet och prestandanivåer, och det kanske aldrig händer.

Vi har nu haft en chans att se hur DLSS 3 ser ut och känns i aktion. Det är inte riktigt lika fantastiskt som Nvidias påståenden. Eftersom det inte finns någon ytterligare användarinmatning som beaktas i de beräknade ramarna, plus de två extra latensramarna (relativt den genererade bildhastigheten) kan DLSS 3 se bättre ut än det känns. Ta ett spel som En pestberättelse: Requiem Kör på 100 fps med DLSS 2 -uppskalning, och ramgenerering kan öka det till 140–150 fps. Men det känns mer som kanske 110–120 fps i bästa fall, enligt vår mening. Vid lägre pre-frameGen Framerates, som att säga 30 fps, kan du få dubbelt så bra prestanda till 60 fps, men det kommer fortfarande att känns som 30 fps.

DLSS 3 kräver för närvarande att RTX 40-seriens kort körs, åtminstone med ramgenerering aktiverad. Det kommer att vara en extra inställning som användare kan välja att aktivera; Utan det stöder DLSS 3 fortfarande Core DLSS 2-uppskalningsalgoritmen och kräver också att utvecklare använder NVIDIA Reflex, så utvecklare som väljer DLSS 3 stöder RTX 40-serien samt tidigare RTX-seriekort.

Ada får AV1 -kodning, gånger två

Nvidias GeForce RTX 4090, 4080 och 4070 TI-grafikkort kommer att innehålla två av dess åttonde generationens NVIDIA-kodare (Nvenc) hårdvaruenheter. För RTX 4070 och lägre modeller finns det bara en enda Nvenc -enhet. Dessa kommer också att ha stöd för AV1 -kodning, liknande Intel Arc – förutom att det finns två istället för bara en. Vi har nyligen genomfört djupgående testning av videokodningsprestanda och kvalitet och jämför de senaste GPU: erna med tidigare generationer.

AV1 -kodning förbättrar effektiviteten med 40% enligt NVIDIA, men det verkar jämföras med H.264 (det är mest likadant i bitrater och effektivitet som hevc/h.265). Det betyder att alla livestreams som stöder codec skulle se ut som om de hade en 40% högre bitrate än den nuvarande h.264 bäckar. Naturligtvis kommer strömningstjänsten att behöva stödja AV1 för att detta ska vara viktiga.

De två kodarna kan dela upp arbetet mellan dem, så kodningsprestanda fördubblas potentiellt för eventuell arbetsbelastning, även om GPU bara kodar för en enda ström. Eller åtminstone det är teorin; I praktiken såg vi inga större förändringar när vi använde FFMPEG jämfört med tidigare Nvenc -hastigheter. Videoredaktörer kan dra nytta av prestationsförstärkningen, och NVIDIA arbetade med DaVinci Resolve, Handbrake, Voukoder och Jianying för att möjliggöra stöd.

GeForce Experience och Shadowplay kommer också att använda den nya hårdvaran, vilket gör att spelare kan fånga spel på upp till 8K och 60 FPS i HDR. Perfekt för 0.01% av människor som kan se infödda 8K -innehåll! (Om du bygger det kommer de. ) Också nvenc -enheterna kan fortfarande hantera h.264, HEVC och andra format bara bra.

Tidiga rapporter om 600W och högre TBP: er (total styrelsekraft) för ADA verkar mestadels vara ogrundad, åtminstone på de tillkännagivna Founders Edition -modellerna. I själva verket, efter att ha testat sex olika RTX 4090 -kort, även med manuell överklockning bröt vi inte konsekvent 600W. RTX 4090 har samma 450W TGP som den utgående RTX 3090 TI, medan RTX 4080 sjunker det till bara 320W, RTX 4070 TI har en 285W TGP, och RTX 4070 Lands vid 200W. De är för referens Grundare Edition -modeller dock.

Som vi har sett med RTX 3090 Ti och andra Ampere GPU: er är vissa AIB (tilläggskort) partner mer än glada över att ha väsentligt högre kraftdragning i strävan efter varje sista ounce av prestanda. RTX 4090 Anpassade kort som drar upp till 600W.

Allt går tillbaka till slutet av Dennard Scaling, rätt tillsammans med döden av Moores lag. Enkelt uttryckt, Dennard Scaling – även kallad MOSFET -skalning – observerade att med varje generation kunde dimensioner skalas ned med cirka 30%. Det minskade det totala området med 50% (skalning i både längd och bredd), spänningen tappade en liknande 30%, och kretsförseningar skulle minska med 30% också. Dessutom skulle frekvenserna öka med cirka 40% och den totala strömförbrukningen skulle minska med 50%.

Om allt låter för bra för att vara sant, beror det på att Dennard Scaling effektivt slutade omkring 2007. Liksom Moores lag misslyckades det inte helt, men vinsterna blev mycket mindre uttalade. Klockhastigheter i integrerade kretsar har endast ökat från högst 3.7GHz 2004 med Pentium 4 Extreme Edition till dagens maximum 5.5 GHz i kärnan i9-12900ks. Det är fortfarande nästan en 50% ökning av frekvensen, men det har kommit över Sex generationer (eller mer, beroende på hur du vill räkna) för förbättringar av processnoden. Sagt på ett annat sätt, om Dennard Scaling inte hade dött, skulle moderna CPU klocka så högt som 28 GHz. RIP, Dennard Scaling, du saknas.

Det är inte bara frekvensskalningen som dog, utan också kraft och spänningsskalning. Idag kan en ny processnod förbättra transistortätheten, men spänningar och frekvenser måste vara balanserade. Om du vill ha ett chip som är dubbelt så snabbt, kan du behöva använda nästan dubbelt så mycket kraft. Alternativt kan du bygga ett chip som är mer effektivt, men det blir inte snabbare. NVIDIA verkar gå efter mer prestanda med ADA, även om det inte helt har kastat effektivitetsproblem ut genom fönstret.

Titta bara på RTX 4070 Ti som ett exempel. Vår testning visar att det är nära den föregående generationen RTX 3090 TI i prestanda, medan du drar 37% mindre kraft. I vissa fall, som med DLSS 3 och tunga RT -arbetsbelastningar, kan det till och med fördubbla prestandan medan du fortfarande använder mindre kraft. .

RTX 40-serien prissättning

Hur mycket kommer RTX 40-serien GPU att kosta? Det korta svaret och Sann Svar, är att de kommer att kosta så mycket som nvidia och återförsäljare kan komma undan med att ladda. NVIDIA lanserade Ampere med en uppsättning finansiella modeller, och de visade sig vara helt fel för Covid Pandemic -eran. Verkliga priser sköt upp och scalpers profitered, och det var innan Cryptocurrency gruvarbetare började betala två till tre gånger de officiella rekommenderade priserna.

Den goda nyheten är det GPU -priser har kommit ner, och Ethereum Mining har slutat. Det har i sin tur absolut dödat GPU -lönsamhet för gruvdrift, med de flesta kort som nu kostar mer att köra än de kunde göra av strävan. Det är allt bra att höra, men det garanterar fortfarande inte rimliga priser.

Vad gör du när du har ett gäng befintliga kort att sälja? Du gör att de nya korten kostar mer. Vi ser det med lanseringspriserna på RTX 4090, 4080, 4070 TI och 4070 -modellerna. 4090 är $ 1 599, $ 100 mer än 3090 lanseringspriset och långt utom räckhåll för de flesta spelare. RTX 4080 är inte mycket bättre på $ 1,199, och RTX 4070 TI kostar $ 799, $ 100 mer än RTX 3080 10 GB -lanseringen MSRP och $ 200 mer än den utgående RTX 3070 TI – och det var inte förrän i slutet av 2022 som vi till och med såg såg såg 30-seriens kort säljer i detaljhandeln för nära sina MSRP: er!

Det ser ut som att NVIDIA lyckades rensa ut tillräckligt med sin befintliga RTX 30-serie inventering, och RTX 40-seriens kort upprätthåller sina höga priser. De flesta är nu tillgängliga från MSRP, eller åtminstone nära det, även om RTX 4090 fortfarande kan beordra en premium. Det är troligt att det också plockas upp för professionellt arbete, inklusive AI och Deep Learning Research. Den nya RTX 4060 TI och 4060 sätter åtminstone ADA till liknande prispunkter som deras föregångare.

. NVIDIA måste också tävla med AMD och Radeon RX 7000-serien och RDNA 3 GPU: er, men de är också dyra. Nvidia var långsammare för att driva ut ytterligare GPU: er som RTX 4070 och nedan, även om mainstream 4060 Ti och nedan är tillbaka till prisparitet med sina föregångare. Förhoppningsvis kommer de framtida modellerna (särskilt RTX 4050 att fortsätta att trenda nedåt och nå mer rimliga kostnadsnivåer utan att helt axla prestanda.

Grundare Edition Designförändringar

NVIDIA gjorde många påståenden om sin nya Founders Edition -kortdesign vid lanseringen av RTX 3080 och 3090. Medan korten i allmänhet fungerar bra, är det vi har upptäckt under de senaste två åren att traditionella axiella kylkort från tredje parts AIC -partners tenderar att svalna bättre och springa tystare, även när vi använder mer kraft. GeForce RTX 3080 TI Founders Edition var ett särskilt otroligt exempel på hur temperaturer och fläkthastigheter inte kunde hålla jämna steg med hetare GPU: er.

Den huvudsakliga skyldigheten verkar vara GDDR6X -minnet, och NVIDIA kommer inte att packa Mer GDDR6X till ADA än i Ampere, åtminstone när det gäller det totala antalet chips. Nvidia noterar emellertid att den har fungerat med Micron (den exklusiva tillverkaren av GDDR6X) för att minska strömförbrukningen från den senaste generationens chips. Det borde verkligen hjälpa frågor, och medan Micron gör 24 Gbps GDDR6X, hittills inte går NVIDIA inte så högt på minnesklockor.

RTX 4090 kommer att ha tolv 2 GB -chips, precis som 3090 Ti, medan 4080 skär det till åtta chips och 4070 Ti bara behöver svalna sex chips. Med en process krymp från Micron på GDDR6X-chips, plus bättre termiska kuddar, får vi RTX 40-seriens kort som i allmänhet inte går nästan lika heta som de tidigare modellerna. NVIDIA minskade också termisk dyna tjocklek med RTX 40-serien för att bättre hjälpa till med värmeöverföring från minnet till kylflänsen.

Det är intressant att notera att av de sex RTX 4090 -korten som vi testade kom ungefär hälften med en annan klass av GDDR6X -minne. Dessa kort tenderade att visa VRAM -temperaturer som toppade vid 65–70 grader Celsius, medan de andra korten skulle nå 80–85C. Vårt antagande är att de lägre temperaturkorten faktiskt använder Microns 24 Gbps -chips med en förbättrad processnod, bara märkt och sålt som 21 Gbps. RTX 4080 hittills är det enda kortet som kräver snabbare chips, och dessa kort också tenderar att träffa

När det gäller kortdesign, till och med RTX 4080 kommer in på trippel-slot-åtgärden denna omgång, vilket är en intressant taktförändring. Det är “enda” en 320W TBP, men sedan körde 3080 Fe och 3080 Ti Fe alltid mer än lite toasty. 285W TBP på 4070 Ti kan få två-slotbehandlingen från några av AIB-partnerna, men NVIDIA kommer inte att göra en 4070 TI Founders Edition-den speciella GPU kommer bara från tredjepartskort. RTX 4070 har en Founders Edition, och RTX 4060 TI 8GB kommer också att ha en Founders Edition. RTX 4060 TI 16GB och RTX 4060 kommer endast att erbjudas som anpassade kort från Nvidias AIB -partners.

ADA GPU -släppdatum

Nu när de stora avslöjningarna och de första lanseringarna är över, vet vi att RTX 4090 anlände den 12 oktober, RTX 4080 lanserades den 16 november och RTX 4070 TI anlände den 5 januari (efter att ha bytt namn från RTX 4080 12 GB och släppt MSRP $ 100). RTX 4070 landade den 13 april, och RTX 4060 TI 8GB kommer att lanseras den 24 maj. Vi vet att RTX 4060 TI 16GB och RTX 4060 kommer att anlända i juli, men vi har inte exakta datum än. . Det kan också finnas andra ADA -grafikkortsuppdateringar.

NVIDIA lanserade RTX 3080 och RTX 3090 i september 2020, RTX 3070 anlände en månad senare, sedan RTX 3060 TI anlände drygt en månad efter det. RTX 3060 kom inte ut förrän i slutet av februari 2021, sedan uppdaterade NVIDIA serien med RTX 3080 TI och RTX 3070 TI i juni 2021. Den budgetvänliga RTX 3050 anlände inte förrän januari 2022, och slutligen lanserades RTX 3090 TI i slutet av mars 2022.

. Det är nu över och gjort så långt vi kan säga, och vi väntar bara på att de slutliga modellerna ska dyka upp.

Vi behöver fortfarande verkliga budgeterbjudanden för att ta över GTX 16-serien. Kan vi få en ny GTX -serie, eller ett riktigt budget RTX -kort för under $ 200? . I bästa fall kan RTX 3050 sjunka till $ 200 under de kommande månaderna, men vi skulle inte bli förvånade över att se NVIDIA helt överge under- 200 $ grafikkortsmarknaden. Vi misstänker att RTX 4050, när som anländer, kommer att ta över priset på $ 250.

Det finns vanligtvis en uppdatering av GPU: er ungefär ett år efter den första lanseringen, och vi kommer nära det märket nu. Oavsett om de slutar vara “TI” -modeller eller “super” -modeller eller något annat är någons gissning, men du kan ganska mycket markera det på din kalender. GeForce RTX 40-seriens uppdatering, som kommer hösten 2023.

Konkurrens i GPU -utrymmet

Nvidia har varit den dominerande spelaren i grafikkortutrymmet i ett par decennier nu. Den kontrollerar ungefär 80% av den totala GPU -marknaden och 90% eller mer av den professionella marknaden, vilket till stor del har tillåtit den att diktera skapandet och antagandet av ny teknik som Ray Tracing och DLSS. Men med den fortsatta ökningen av vikten av AI och beräknar för vetenskaplig forskning och andra beräkningsarbetsbelastningar, och deras beroende av GPU-liknande processorer, ser många andra företag att bryta sig in i branschen, bland dem är Intel.

Intel hade inte gjort ett ordentligt försök på ett dedikerat grafikkort sedan slutet av 90 -talet, såvida du inte räknar den övergivna Larrabee. Den här gången verkar Intel Arc Alchemist vara den verkliga affären – eller åtminstone foten i dörren. Intel erbjuder bra mediefunktioner, och ARC: s spel och allmänna datorprestanda är bra, men de är verkligen inte tillräckliga för att tävla med avancerade AMD- och NVIDIA-kort. Istället går Intel för mainstream till budgetsektorn. tills vidare.

Men ARC Alchemist är bara den första i en regelbunden kadens av GPU -arkitekturer som Intel har planerat. Battlemage kan lätt fördubbla Alchemists kapacitet, och om Intel kan få ut det förr än senare, kan det börja äta in i Nvidias marknadsandel, särskilt i spelets bärbara utrymme. JPR indikerar att ARC uppnådde en ganska imponerande 6% av den globala försäljningsmarknaden i slutet av 2023, men att släppa priserna tyder på att försäljningen för ARC inte är nästan lika hög.

AMD kommer inte heller att stå stilla, och den lanserade framgångsrikt sin RDNA 3 -arkitektur i december 2022. AMD har flyttat till TSMC: s N5 -nod för GPU -chipletterna, men den kommer också att använda N6 -noden för minneschipletterna. AMD vägrar fortfarande att lägga någon betydande mängd djup inlärningshårdvara i sina konsument GPU: er (till skillnad från sin MI200 -serie), vilket gör att den kan fokusera på att leverera prestanda utan att oroa sig lika mycket för uppskalning – även om FSR 2.0 täcker det också och fungerar på alla GPU: er. Men i AI -utrymmet betyder det att AMD: s konsument GPU faller bakom.

AMD har också RX 7600 kommer snart och använder TSMC N6 – inte en massiv uppdatering från föregående generation, med andra ord. Hittills har AMD endast meddelat eller släppt mobila varianter av sina RX 7700 och 7800 klass GPU: er.

Det finns ingen tvekan om att Nvidia för närvarande levererar mycket överlägsen strålspårningsprestanda än AMD: s RX 7000- och 6000-serie kort. AMD har inte varit nästan lika stämma om Ray Tracing Hardware eller behovet av RT -effekter i spel. Intel för sin del levererar anständiga (mainstream) RT -prestanda, men bara upp till nivån på RTX 3060, ge eller ta. Men så länge de flesta spel fortsätter att springa snabbare och ser bra ut utan RT -effekter, är det en uppåtgående strid som övertygar människor att uppgradera sina grafikkort.

NVIDIA RTX 40-serien Stängande tankar

Vi hade två långa år av GPU-torka och överdrivna kort för NVIDIAs tidigare generation AMPERE / RTX 30-serien GPUS. Slutet av 2022 markerade ankomsten av de första nästa gen-GPU: erna, men de var alla mycket dyra, började på $ 800 minimum. 2023 formar sig under tiden för att bli bättre för dem som vill köpa en mainstream -uppgradering.

Förhoppningsvis kommer denna omgång att se mycket bättre tillgänglighet och prissättning. Det kan knappast vara värre än vad vi såg 2020–2022.

Läs våra fullständiga recensioner av RTX 40-seriens kort för ytterligare testning och resultat:

Asus GeForce RTX 40 -serien

Asus utnyttjar den extraotrdinära kraften hos NVIDIA GeForce RTX ™ 40 -serien GPU för att leverera grafikkort med en mängd avancerad teknik, prestationsgenombrott och premiumutseende som du inte hittar någon annanstans. Från de vätskekylda matrisen RTX 4090 Med de högsta boostklockorna utanför boxen på marknaden, till de minimalistiska proart-skapare-fokuserade korten, kommer användare av varje rand att hitta något från ASUS som överträffar förväntningarna. Axial-Tech-fans, ångkammarskylning, smart kompakta design, GPU Tweak III-app, fullt stöd för NVIDIA Studio-det är allt här, väntar på dig.

HKEPC -redaktörens val

ROG STRIX GEFORCE RTX 4090 OC -utgåva anpassade den senaste 3.5 Slot Axial-Tech-fans som är starka kylfunktioner

8.5 av 10

Det har allt du kan vilja ha från ett anpassat kort, till exempel en fabriksöverklocka, en mycket kapabel och tyst svalare och en attraktiv design. Det nya utseendet är en uppfriskande avvikelse från tidigare ROG -strixkort, och den blygsamma RGB -belysningen ger en mer smakfull och dämpad estetik.

2023 Red Dot Product Design

Rog Strix GeForce RTX 40-serien vann 2023 Red Dot Product Design Award, ett världsberömt designpris.

Redaktörens val

Den nya ASUS Republic of Gamers (ROG) Strix GeForce RTX 4090 OC representerar den allra bästa luftkylda skräddarsydda implementeringen av det nya NVIDIA-flaggskeppet som ASUS har att erbjuda, och vi granskar det idag.

Ett utmärkt exempel i byggkvaliteten

Detta är versionen för överklockare, tack vare den utmärkta kylning och låga brusproduktion.

93/100

ASUS ROG Strix RTX4090 OC har också en väldigt cool snygg, med en semi-retro-rundad kapsling och RGB-glödande galler på baksidan för en Cyberpunk industriell design, samt en anständig kylprestanda. Om du funderar på att uppgradera ditt gamla grafikkort är detta definitivt ett bra val.

91%

Asus slår ner med sin flaggskepp Rog Strix GeForce RTX 4090 OC Edition Graphics Card, där kortets utformning tar centrum. Du kommer inte att titta bort från det här kortet, eftersom det har en super-unik stil som går ut ur den regelbundna estetiken som företaget har använt i tidigare Rog Strix-grafikkort.

prestanda först

Den här gången lanserade NVIDIA en ny generation av RTX 40 -serien grafikkort, och ASUS lanserade också flaggskeppet Rog Strix GeForce RTX 4090 OC grafikkort. För att möta den nya high-end-kärnan RTX 4090 har den nyligen designade kylaren en större storlek, och boostklockan når 2640 MHz under inställning och pressar ut så mycket prestanda som möjligt för spelare.

Red Dot Design Award: TUF Gaming GeForce RTX 40 Series

TUF Gaming GeForce RTX 40-serien vann 2023 Red Dot Product Design Award, ett världsberömt designpris.

Asus GeForce RTX 4070 Dual Review – Value & Slutsats | Techpowerup

Asus Dual sticker ut tack vare dess extremt låga brus, dubbla bios och kort formfaktor.

VIDEOKLIPP

Asus Proart med Nvidia Studio

Asus Rog med NVIDIA DLSS 3 – Better. Snabbare. Starkare.

ROG STRIX GEFORCE RTX 4090 & NVIDIA DLSS 3

Asus Rog med Nvidia Reflex

Empowering kreativitet med Asus Proart | Modsbyben

Asus TUF Gaming GeForce RTX 4070 – Officiell unboxing

Asus TUF Gaming GeForce RTX 4060 TI – Officiell unboxing

Asus GeForce RTX ™ 4080 Noctua Edition | Första titt

Axialtekniska uppgraderingar

Större och bättre. Axial-tech-fläktar snurrar på dubbla bolllager och har skalats upp för att driva 23% mer luft genom kortet, vilket sätter scenen för lägre temperaturer, mindre brus och högre prestanda.

De två sidosfläktarna snurrar moturs för att minimera turbulens och maximera luftdispersionen genom kylflänsen. Alla tre fans stannar när GPU-temps är under 50 Celsius, så att du låter dig spela mindre krävande spel eller utföra lätta uppgifter i relativ tystnad. Fans startar igen när temps är över 55 C, som hänvisar till en hastighetskurva som balanserar prestanda och akustik för arbete eller lek.

Premium kraftleverans

Digital kraftkontroll, en mängd högströmmar och en sortiment av 15K-mössor säkerställer massiva reserver för att pålitligt driva prestationsgränser.

Kompakt PCB

Komponent- och spårlayouter har optimerats på en kort PCB en massiv bakplattor.

Gå med strömmen

Allt samlas för att enkelt driva GeForce RTX 4090 -prestanda till max.

Asus GPU Tweak III

Asus GPU Tweak III (nedladdning) är mer intuitiv och funktionsrik än någonsin tidigare. . Ytterligare godsaker som 0db-fläktteknologi, automatisk profilbyte, en helt anpassningsbar skärm på skärmen och loggningsfunktioner säkerställer att du får ut det mesta av ditt grafikkort.

Realistiskt försvara och slå 40 -seriens prissättning. (Lång läsning / diskussion)

Diskutera verkligen, TLDR är på förhand, så om inte vill läsa för att döda tiden, bara passera, inte tldr för att du inte har något bättre att göra, skulle uppskattas.

Jag menar, tidigare att presentera . Du har det första 1K -spelkortet, 2080ti, som inte fick så mycket flack för att vara 1199, (jag menar inte få det tvinnat, det var lite skrik) men inte som ropet över 40 serier. Men allt som överskuggas av Titan RTX “$ 2499” men det rekommenderas inte för spelare, även om det slår (korn) en 2080ti i spel. Alla som 75% av människor klagade, jävla, 1k för 2080ti men sparade fortfarande för att få en!

Gå framåt, säger Nvidia, hej, vi kommer att ge dig ett ännu kraftfullare kort till halva priset! Jippie!, Men ingen förutsåg krypto b.s. .

Låt oss lösa det, från företagets synvinkel, HRRMM, låter släpp 3090 Ti till $ 2k och se vad som händer. DE SÅLDE.. Så om “jag” var nvidia, ja sir, denna demoniska 4090 (FE) är en helluva -affär om du suger köpte 3090ti på 2k och köpte 3070 -tal till $ 1k så som ett företag, varför skulle jag inte driva den bästa kortperioden 1599. Jag menar, du får ett Titan -klasskort för mindre än 2k som alltid har varit vår Titan Class -prissättning.

Gå vidare, 3080 Ti släppt och accepterades 50%, eftersom hej ,, det är i princip en 3090 för sätt mindre, bara saknas hälften av VRAM, så nu 4080 (är i princip 3080 ti -priset detta men wayyyyy mer prestanda) så mycket hata. Hrmm. är meningslöst.

4070 TI är en odjurmordare på 2080ti och billigare så jag känner mig mer så att folk klagar över kortet “80” -klassen är $ 1200 mot det faktum att 80 klasskort är Titan -status. Om 4080 var mindre kraftfull eller lika med 3090 eftersom cykeln ganska mycket alltid har varit och 4080 prissattes till $ 100 mer än 3080, skulle det vara den normala årliga evenemangscykeln, men 40 serier kastade i princip Titan+ Power i en 80/ 90 klasskort och stötte priset som sådant. Men allt vi ser är “80” eller “90” och med en 1.2k prislapp som 80 klass inte ska vara.

Så de testade marknaden med 2080 Ti, folk köpte den, skalpande visade dem bara, welp, så dåliga som ppl är, de betalade fortfarande dessa priser, så 799, 1299 och 1599 är bara bra, plus kraften upplyftning. Jag känner att Nvidia gjorde exakt vad ett företag ska göra.

Men när mobiltelefoner träffade 1K och stannade, är det enda # som driver förbi 1K för telefoner mer TB -lagring, men basen är 1K i princip för en flaggskeppstelefon. Jag tycker att GPU borde vara desamma, vilket innebär att 1k borde vara max men om du behöver mer RAM (för ppl som faktiskt arbetar med GPU) betala 1200 för 16 GB, 1400 för 24 GB, men oavsett, de alla 4090 eller vad som helst. GPU -priser är för jävla höga, men det är affärer, gillar det inte, gör din egen GPU.

2080 TI $ 1200 – Accepterad av 80% av folket, 3080 $ 700, accepterat av 100% av folket, men från lanseringen gjorde lågt lager det $ 1000 och 75% av människorna fortfarande köpte. Crypto Mining Det träffade $ 1600-1800, och 50% av människor köpte fortfarande det, så vem är det som är det? Visst ingen nvidia, men våra dumma åsnor (inte överför dig eller mig) men oss som konsumenter som helhet.

Vad vi gör med 4080 nu, vi borde ha gjort med 30 -seriens hårbotten “år”, men nooooooo för ett helt jävligt år, människor betalade outlandiska priser, så inte konstigt att Nvidia prissatt som sådan.

Detta är “fullt på diskussion” som är tänkt att läsas, och funderade, riktiga svar och långa rövkommentarer/tankar välkomna. Låt oss komma till botten av det!

Min personliga tanke: 4080 pris är för högt, men rättvist från NVIDIA -vy, och vi kunde ha en 999 4080 hade så många människor inte betalat priserna på hårbotten på en vanlig.